Hướng dẫn cơ bản về robots.txt

Hướng dẫn cơ bản về robots.txt – Tệp robots.txt là một trong những cách chính để cho công cụ tìm kiếm biết nơi nó có thể và không thể truy cập trên trang web của bạn. Tất cả các công cụ tìm kiếm chính đều hỗ trợ chức năng cơ bản của nó, nhưng một số công cụ lại đáp ứng các quy tắc bổ sung, điều này cũng có thể hữu ích. Hướng dẫn này bao gồm tất cả các cách sử dụng robots.txt trên trang web của bạn.

Hướng dẫn cơ bản về robots.txt là gì? Bài viết dưới đây sẽ giải thích cho bạn:

-

txt là gì?

Tệp robots.txt là một trong số các lệnh thu thập thông tin. Chúng tôi có hướng dẫn về tất cả chúng và bạn sẽ tìm thấy chúng ở đây.

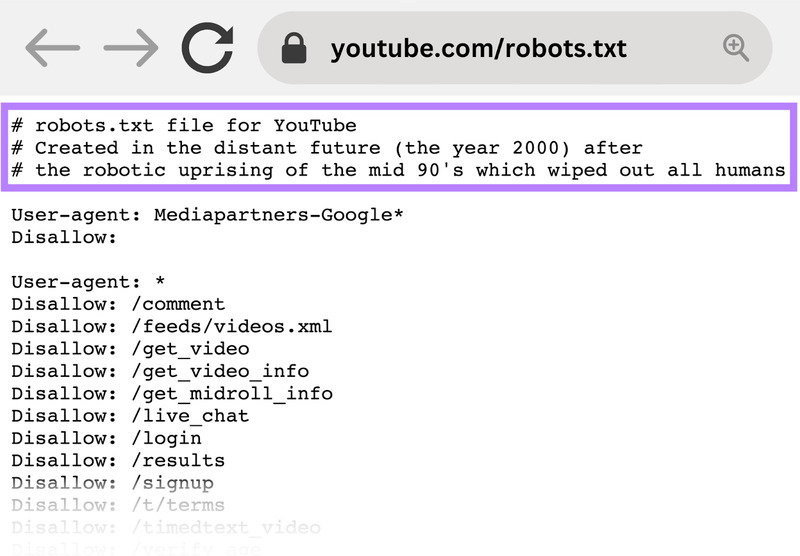

Tệp robots.txt là một tài liệu văn bản thuần túy nằm trong thư mục gốc của trang web, đóng vai trò như một bộ hướng dẫn cho các bot công cụ tìm kiếm. Còn được gọi là Giao thức loại trừ robot, tệp robots.txt là kết quả của sự đồng thuận giữa các nhà phát triển công cụ tìm kiếm ban đầu. Đây không phải là tiêu chuẩn chính thức do bất kỳ tổ chức tiêu chuẩn nào đặt ra, mặc dù tất cả các công cụ tìm kiếm lớn đều tuân thủ nó.

Robots.txt chỉ định những trang hoặc phần nào cần được thu thập thông tin và lập chỉ mục và những trang hoặc phần nào nên bỏ qua. Tệp này giúp chủ sở hữu trang web kiểm soát hành vi của trình thu thập dữ liệu của công cụ tìm kiếm, cho phép họ quản lý quyền truy cập, giới hạn lập chỉ mục ở các khu vực cụ thể và điều chỉnh tốc độ thu thập dữ liệu.

Mặc dù đây là một tài liệu công khai, việc tuân thủ các chỉ thị của nó là tự nguyện nhưng nó là một công cụ mạnh mẽ để hướng dẫn các bot công cụ tìm kiếm và tác động đến quá trình lập chỉ mục.

Tệp robots.txt cơ bản có thể trông giống như thế này:

User-Agent: *

Disallow:

Sitemap: https://www.example.com/sitemap_index.xml

-

txt có tác dụng gì?

Các công cụ tìm kiếm thường lưu vào bộ nhớ đệm nội dung của robots.txt để không cần tiếp tục tải xuống nhưng thường sẽ làm mới nội dung đó vài lần trong ngày. Điều đó có nghĩa là những thay đổi đối với hướng dẫn thường được phản ánh khá nhanh.

Công cụ tìm kiếm khám phá và lập chỉ mục trang web bằng cách thu thập dữ liệu các trang. Khi thu thập thông tin, họ khám phá và lần theo các liên kết. Việc này đưa họ từ trang A đến trang B rồi đến trang C, v.v. Nhưng trước khi công cụ tìm kiếm truy cập bất kỳ trang nào trên miền mà nó chưa gặp, nó sẽ mở tệp robots.txt của miền đó. Điều đó cho họ biết URL nào trên trang web đó họ được phép truy cập (và URL nào không).

-

txt của mình ở đâu?

Tệp robots.txt phải luôn nằm ở thư mục gốc của miền của bạn. Vì vậy, nếu tên miền của bạn là www.example.com, trình thu thập thông tin sẽ tìm thấy nó tại https://www.example.com/robots.txt.

Điều quan trọng nữa là tệp robots.txt của bạn phải được gọi là robots.txt. Tên có phân biệt chữ hoa chữ thường, vì vậy hãy hiểu đúng, nếu không nó sẽ không hoạt động.

-

txt

Plugin của chúng tôi có các giá trị mặc định hợp lý nhưng bạn luôn có thể thay đổi mọi thứ khi bạn thấy phù hợp. Yoast SEO cung cấp giao diện thân thiện với người dùng để chỉnh sửa tệp robots.txt mà không cần truy cập thủ công. Với Yoast SEO, bạn có thể truy cập và định cấu hình tính năng robots.txt thông qua cài đặt của plugin. Nó cho phép bạn bao gồm hoặc loại trừ các khu vực trang web cụ thể khỏi bị công cụ tìm kiếm thu thập dữ liệu. Khi được sử dụng cùng với cài đặt thu thập thông tin,

-

txt

-

Chuyên nghiệp: quản lý ngân sách thu thập dữ liệu

Người ta thường hiểu rằng một con nhện tìm kiếm đến một trang web với “giới hạn” được xác định trước về số lượng trang nó sẽ thu thập thông tin (hoặc lượng tài nguyên/thời gian nó sẽ sử dụng, dựa trên quyền hạn/quy mô/danh tiếng của trang web và cách thức máy chủ phản hồi một cách hiệu quả). SEO gọi đây là ngân sách thu thập dữ liệu.

Nếu bạn cho rằng trang web của mình có vấn đề với ngân sách thu thập dữ liệu, việc chặn các công cụ tìm kiếm khỏi ‘lãng phí’ năng lượng vào những phần không quan trọng trên trang web của bạn có thể có nghĩa là thay vào đó hãy tập trung vào những phần quan trọng. Sử dụng cài đặt dọn dẹp thu thập thông tin trong Yoast SEO để giúp Google thu thập thông tin quan trọng.

Đôi khi, việc chặn các công cụ tìm kiếm thu thập dữ liệu các phần có vấn đề trên trang web của bạn có thể có ích, đặc biệt là trên các trang web phải thực hiện nhiều thao tác dọn dẹp SEO. Khi bạn đã dọn dẹp xong mọi thứ, bạn có thể để chúng quay trở lại.

-

Lưu ý về việc chặn tham số truy vấn

Một tình huống mà ngân sách thu thập dữ liệu rất quan trọng là khi trang web của bạn sử dụng nhiều tham số chuỗi truy vấn để lọc hoặc sắp xếp danh sách. Giả sử bạn có mười tham số truy vấn khác nhau, mỗi tham số có các giá trị khác nhau có thể được sử dụng trong bất kỳ kết hợp nào (chẳng hạn như áo phông có nhiều màu sắc và kích cỡ).

Điều này dẫn đến nhiều URL hợp lệ có thể có, tất cả đều có thể được thu thập thông tin. Việc chặn thu thập thông tin các tham số truy vấn sẽ giúp đảm bảo công cụ tìm kiếm chỉ thu thập dữ liệu các URL chính của trang web của bạn và sẽ không rơi vào cái bẫy nhện khổng lồ mà bạn thường tạo ra.

-

Nhược điểm: không xóa một trang khỏi kết quả tìm kiếm

Mặc dù bạn có thể sử dụng tệp robots.txt để cho trình thu thập thông tin biết nó không thể truy cập vào đâu trên trang web của bạn, nhưng bạn không thể sử dụng tệp đó để thông báo cho công cụ tìm kiếm biết URL nào không hiển thị trong kết quả tìm kiếm – nói cách khác, việc chặn nó sẽ không ngăn nó được lập chỉ mục. Nếu công cụ tìm kiếm tìm thấy đủ liên kết tới URL đó, nó sẽ bao gồm URL đó; nó sẽ không biết những gì trên trang đó. Vì vậy, kết quả của bạn sẽ trông như thế này:

Sử dụng thẻ meta robot noindex nếu bạn muốn chặn một trang xuất hiện trong kết quả tìm kiếm một cách đáng tin cậy. Điều đó có nghĩa là để tìm thấy noindexthẻ, công cụ tìm kiếm phải có khả năng truy cập trang đó, vì vậy đừng chặn trang đó bằng robots.txt.

-

Chỉ thị Noindex

Trước đây, bạn có thể thêm lệnh ‘noindex’ trong robots.txt của mình để xóa URL khỏi kết quả tìm kiếm của Google và tránh những ‘đoạn’ này hiển thị. Điều này không còn được hỗ trợ (và về mặt kỹ thuật, chưa bao giờ được hỗ trợ).

-

Nhược điểm: không lan truyền giá trị liên kết

Nếu công cụ tìm kiếm không thể thu thập dữ liệu một trang thì nó không thể truyền bá giá trị liên kết trên các liên kết trên trang đó. Đó là ngõ cụt khi bạn đã chặn một trang trong robots.txt. Bất kỳ giá trị liên kết nào có thể đã chảy đến (và xuyên qua) trang đó đều bị mất.

-

txt

-

txt

Chúng tôi có một bài viết về cách tốt nhất để thiết lập robots.txt cho WordPress. Đừng quên bạn có thể chỉnh sửa tệp robots.txt của trang web trong phần Công cụ SEO Yoast → Trình chỉnh sửa tệp.

Tệp robots.txt bao gồm một hoặc nhiều khối lệnh, mỗi khối bắt đầu bằng một dòng tác nhân người dùng. “Tác nhân người dùng” là tên của con nhện cụ thể mà nó xử lý. Bạn có thể có một khối cho tất cả các công cụ tìm kiếm, sử dụng ký tự đại diện cho tác nhân người dùng hoặc các khối cụ thể cho các công cụ tìm kiếm cụ thể. Một công cụ tìm kiếm sẽ luôn chọn khối phù hợp nhất với tên của nó.

Các khối này trông như thế này (đừng sợ, chúng tôi sẽ giải thích bên dưới):

Tác nhân người dùng: *

Không cho phép: /

Tác nhân người dùng: Googlebot

Không cho phép:

Tác nhân người dùng: bingbot

Không cho phép: /not-for-bing/

Các chỉ thị thích Allowvà Disallowkhông nên phân biệt chữ hoa chữ thường, vì vậy bạn có thể viết chúng bằng chữ thường hoặc viết hoa. Các giá trị phân biệt chữ hoa chữ thường, do đó /photo/không giống với /Photo/. Chúng tôi thích viết hoa các lệnh vì nó làm cho tệp (đối với con người) dễ đọc hơn.

-

Chỉ thị tác nhân người dùng

Bit đầu tiên của mỗi khối chỉ thị là tác nhân người dùng, xác định một con nhện cụ thể. Trường tác nhân người dùng khớp với tác nhân người dùng (thường dài hơn) của trình thu thập dữ liệu cụ thể đó, do đó, chẳng hạn, trình thu thập dữ liệu phổ biến nhất của Google có tác nhân người dùng sau:

Mozilla/5.0 (tương thích; Googlebot/2.1; +http://www.google.com/bot.html)

Nếu bạn muốn yêu cầu trình thu thập thông tin này phải làm gì thì một User-agent: Googlebotdòng tương đối đơn giản sẽ thực hiện thủ thuật.

Hầu hết các công cụ tìm kiếm đều có nhiều con nhện. Họ sẽ sử dụng một con nhện cụ thể cho chỉ mục thông thường, chương trình quảng cáo, hình ảnh, video, v.v.

Các công cụ tìm kiếm luôn chọn khối chỉ thị cụ thể nhất mà chúng có thể tìm thấy. Giả sử bạn có ba bộ chỉ thị: một cho *, một cho Googlebotvà một cho Googlebot-News. Nếu một bot đi qua có tác nhân người dùng là Googlebot-Video, nó sẽ tuân theo Googlebot restrictions. Một bot có tác nhân người dùng Googlebot-Newssẽ sử dụng Googlebot-Newscác lệnh cụ thể hơn.

-

Các tác nhân người dùng phổ biến nhất cho các công cụ tìm kiếm

Dưới đây là danh sách tác nhân người dùng mà bạn có thể sử dụng trong tệp robots.txt của mình để khớp với các công cụ tìm kiếm được sử dụng phổ biến nhất:

Máy tìm kiếm Cánh đồng Đại lý người dùng

Baidu Tổng quan baiduspider

Baidu Hình ảnh baiduspider-image

Baidu Điện thoại di động baiduspider-mobile

Baidu Tin tức baiduspider-news

Baidu Băng hình baiduspider-video

Bing Tổng quan bingbot

Bing Tổng quan msnbot

Bing Hình ảnh & Video msnbot-media

Bing Quảng cáo adidxbot

Google Tổng quan Googlebot

Google Hình ảnh Googlebot-Image

Google Điện thoại di động Googlebot-Mobile

Google Tin tức Googlebot-News

Google Băng hình Googlebot-Video

Google Thương mại điện tử Storebot-Google

Google Quảng cáo Mediapartners-Google

Google AdWords AdsBot-Google

Yahoo! Tổng quan slurp

Yandex Tổng quan yandex

-

Chỉ thị không cho phép

Dòng thứ hai trong bất kỳ khối lệnh nào là Disallowdòng. Bạn có thể có một hoặc nhiều dòng này, chỉ định phần nào của trang web mà con nhện được chỉ định không thể truy cập. Một Disallowdòng trống có nghĩa là bạn không cho phép bất cứ điều gì để một con nhện có thể truy cập vào tất cả các phần trên trang web của bạn.

Ví dụ bên dưới sẽ chặn tất cả các công cụ tìm kiếm “nghe” robots.txt thu thập dữ liệu trang web của bạn.

Tác nhân người dùng: *

Không cho phép: /

Ví dụ bên dưới sẽ cho phép tất cả các công cụ tìm kiếm thu thập dữ liệu trang web của bạn bằng cách bỏ một ký tự.

Tác nhân người dùng: *

Không cho phép:

Ví dụ bên dưới sẽ chặn Google thu thập Photodữ liệu thư mục trên trang web của bạn – và mọi thứ trong đó.

Tác nhân người dùng: googlebot

Không cho phép: /Photo

Điều này có nghĩa là tất cả các thư mục con của /Photothư mục cũng sẽ không bị dò tìm. Nó sẽ không chặn Google thu thập /photodữ liệu thư mục vì những dòng này phân biệt chữ hoa chữ thường.

Điều này cũng sẽ chặn Google truy cập các URL có chứa /Photo, chẳng hạn như /Photography/.

-

Cách sử dụng ký tự đại diện/biểu thức thông thường

“Chính thức”, tiêu chuẩn robots.txt không hỗ trợ các biểu thức thông thường hoặc ký tự đại diện; tuy nhiên, tất cả các công cụ tìm kiếm lớn đều hiểu nó. Điều này có nghĩa là bạn có thể sử dụng các dòng như thế này để chặn các nhóm tệp:

Không cho phép: /*.php

Không cho phép:

Trong ví dụ trên, *được mở rộng thành bất kỳ tên tệp nào phù hợp với nó. Lưu ý rằng phần còn lại của dòng vẫn phân biệt chữ hoa chữ thường, vì vậy dòng thứ hai ở trên sẽ không chặn việc /copyrighted-images/example.JPGthu thập thông tin tệp có tên.

Một số công cụ tìm kiếm, như Google, cho phép các biểu thức chính quy phức tạp hơn nhưng hãy lưu ý rằng các công cụ tìm kiếm khác có thể không hiểu được logic này. Tính năng hữu ích nhất mà tính năng này bổ sung là $, cho biết phần cuối của URL. Trong ví dụ sau, bạn có thể thấy điều này làm gì:

Không cho phép: /*.php$

Điều này có nghĩa là /index.php không thể lập chỉ mục, nhưng /index.php?p=1 có thể. Tất nhiên, điều này chỉ hữu ích trong những trường hợp rất cụ thể và khá nguy hiểm: rất dễ bỏ chặn những thứ bạn không muốn.

Lệnh thu thập dữ liệu robots.txt không chuẩn

Ngoài các lệnh Disallowvà User-agentlệnh thường được sử dụng, còn có một số lệnh thu thập thông tin khác dành cho tệp robots.txt. Tuy nhiên, điều quan trọng cần lưu ý là không phải tất cả các trình thu thập thông tin của công cụ tìm kiếm đều hỗ trợ các chỉ thị này, vì vậy, điều cần thiết là phải hiểu những hạn chế và cân nhắc của chúng trước khi triển khai chúng.

-

Chỉ thị cho phép

Mặc dù không có trong “đặc điểm kỹ thuật” ban đầu, nhưng đã sớm có thảo luận về lệnh cho phép. Hầu hết các công cụ tìm kiếm dường như đều hiểu nó và nó cho phép đưa ra các chỉ thị đơn giản và rất dễ đọc như thế này:

Không cho phép: /wp-admin/

Cho phép: /wp-admin/admin-ajax.php

Cách duy nhất khác để đạt được kết quả tương tự mà không cần allowchỉ thị là cụ thể disallowtừng tệp trong wp-adminthư mục.

-

Lệnh trì hoãn thu thập thông tin

Độ trễ thu thập dữ liệu là một bổ sung không chính thức cho tiêu chuẩn và rất ít công cụ tìm kiếm tuân thủ nó. Ít nhất Google và Yandex không sử dụng nó, còn Bing thì không rõ ràng. Về lý thuyết, vì trình thu thập thông tin có thể khá thèm thu thập thông tin nên bạn có thể thử crawl-delayhướng làm chậm chúng lại.

Một dòng như dòng bên dưới sẽ hướng dẫn các công cụ tìm kiếm đó thay đổi tần suất họ yêu cầu các trang trên trang web của bạn.

thu thập dữ liệu chậm trễ: 10

Hãy cẩn thận khi sử dụng crawl-delaychỉ thị. Bằng cách đặt độ trễ thu thập dữ liệu là 10 giây, bạn chỉ cho phép các công cụ tìm kiếm này truy cập 8.640 trang mỗi ngày. Điều này có vẻ nhiều đối với một trang web nhỏ nhưng lại không nhiều đối với các trang web lớn. Mặt khác, nếu bạn không nhận được lưu lượng truy cập nào từ các công cụ tìm kiếm này, đó có thể là một cách hay để tiết kiệm băng thông.

-

Chỉ thị sơ đồ trang web dành cho Sơ đồ trang web XML

Bằng cách sử dụng lệnh này sitemap, bạn có thể thông báo cho các công cụ tìm kiếm – Bing, Yandex và Google – nơi tìm thấy sơ đồ trang web XML của bạn. Tất nhiên, bạn có thể gửi sơ đồ trang web XML của mình tới từng công cụ tìm kiếm bằng các công cụ quản trị trang web của họ.

Chúng tôi thực sự khuyên bạn nên làm như vậy vì các công cụ quản trị trang web sẽ cung cấp cho bạn rất nhiều thông tin về trang web của bạn. Nếu bạn không muốn làm điều đó, việc thêm một sitemapdòng vào robots.txt là một giải pháp thay thế nhanh chóng. Yoast SEO tự động thêm liên kết vào sơ đồ trang web của bạn nếu bạn cho phép nó tạo tệp robots.txt. Trên tệp robots.txt hiện có, bạn có thể thêm quy tắc theo cách thủ công thông qua trình chỉnh sửa tệp trong phần Công cụ.

Sơ đồ trang web: https://www.example.com/my-sitemap.xml

-

txt

Từ năm 2015, Google Search Console đã cảnh báo chủ sở hữu trang web không chặn các tệp CSS và JS. Chúng tôi đã nói với bạn điều tương tự từ lâu rồi: đừng chặn các tệp CSS và JS trong robots.txt của bạn. Hãy để chúng tôi giải thích lý do bạn không nên chặn những tệp cụ thể này khỏi Googlebot.

Bằng cách chặn các tệp CSS và JavaScript, bạn đang ngăn Google kiểm tra xem trang web của bạn có hoạt động chính xác hay không. Nếu bạn chặn các tệp CSS và JavaScript trong robots.txt tệp của mình, Google không thể hiển thị trang web của bạn như dự định. Hiện tại, Google không thể hiểu được trang web của bạn, điều này có thể dẫn đến thứ hạng thấp hơn. Hơn nữa, ngay cả những công cụ như Ahrefs cũng hiển thị trang web và thực thi JavaScript. Vì vậy, đừng chặn JavaScript nếu bạn muốn các công cụ SEO yêu thích của mình hoạt động.

Điều này hoàn toàn phù hợp với giả định chung rằng Google đã trở nên “con người” hơn. Google muốn xem trang web của bạn giống như một khách truy cập thực sự, vì vậy nó có thể phân biệt các yếu tố chính với các yếu tố bổ sung. Google muốn biết liệu JavaScript có nâng cao trải nghiệm người dùng hay làm hỏng nó hay không.

-

Kiểm tra và sửa lỗi trong Google Search Console

Google giúp bạn tìm và khắc phục các sự cố với robots.txt của bạn, chẳng hạn như trong phần Lập chỉ mục Trang trong Google Search Console. Chọn tùy chọn Bị chặn bởi robots.txt:

bảng điều khiển lập chỉ mục trang trong bảng điều khiển tìm kiếm của Google hiển thị số trang bị chặn bởi robots.ts

-

txt của bạn chặn

Việc bỏ chặn các tài nguyên bị chặn liên quan đến việc thay đổi robots.txt tệp của bạn. Bạn cần thiết lập tệp đó để nó không cho phép Google truy cập các tệp CSS và JavaScript của trang web của bạn nữa. Nếu bạn đang sử dụng WordPress và sử dụng Yoast SEO, bạn có thể thực hiện việc này trực tiếp bằng plugin Yoast SEO của chúng tôi.

-

txt của bạn

Nhiều công cụ khác nhau có thể giúp bạn xác thực tệp robots.txt của mình nhưng chúng tôi luôn ưu tiên truy cập vào nguồn khi xác thực chỉ thị thu thập thông tin. Google có công cụ kiểm tra robots.txt trong Google Search Console (trong menu ‘Phiên bản cũ’) và chúng tôi thực sự khuyên bạn nên sử dụng công cụ đó:

-

txt trong Google Search Console

Hãy nhớ kiểm tra kỹ các thay đổi của bạn trước khi đưa chúng vào hoạt động! Bạn sẽ không phải là người đầu tiên vô tình sử dụng robots.txt để chặn toàn bộ trang web của mình và rơi vào quên lãng trong công cụ tìm kiếm!

-

txt

Vào năm 2019, Google thông báo họ đang tạo nguồn mở cho trình phân tích cú pháp robots.txt của mình. Nếu muốn tìm hiểu chi tiết, bạn có thể xem mã của chúng hoạt động như thế nào (và thậm chí tự mình sử dụng mã đó hoặc đề xuất sửa đổi).

Xem thêm: Khả năng thu thập thông tin là gì? Khái niệm cơ bản về SEO

Facebook chat

Facebook chat

WhatsApp

WhatsApp